L’indexation des pages web par les moteurs de recherche est un processus crucial pour assurer la visibilité de votre site sur le web. Toutefois, il arrive parfois que vous souhaitiez exclure certaines pages de ce processus. Que ce soit pour des raisons de confidentialité, de stratégie SEO ou simplement parce que ces pages sont redondantes ou peu pertinentes, il est possible de contrôler l’accès des robots d’exploration à vos pages. Il est tout à fait possible d’interdire le crawl d’une page spécifique. Dans cet article, nous vous expliquons les méthodes efficaces pour y parvenir.

La méthode du fichier robots.txt

Le fichier robots.txt est un outil puissant qui vous permet de contrôler l’accès des robots d’exploration à différentes parties de votre site web. Ce fichier, déposé à la racine de votre site, contient des directives spécifiques sur ce que les robots peuvent ou ne peuvent pas explorer.

Qu’est-ce que le fichier robots.txt ?

Le fichier robots.txt est un fichier texte simple qui informe les robots d’exploration des moteurs de recherche sur les URL qu’ils sont autorisés ou non à visiter. En définissant des règles pour différents user agents, vous pouvez contrôler le comportement des robots de façon très précise. Par exemple :

User-agent: *

Disallow: /page-a-exclure/

**User-agent: *** signifie que la règle s’applique à tous les robots. Disallow: /page-a-exclure/ indique que la page spécifique ne doit pas être explorée.

Limites du fichier robots.txt

Bien que le fichier robots.txt soit largement respecté par les moteurs de recherche comme Google, il n’offre pas de garantie absolue. Certains robots malveillants pourraient ignorer ces directives. De plus, les pages exclues ne seront pas explorées, mais elles peuvent quand même être indexées si elles sont liées depuis d’autres sites web. Pour cette raison, il est souvent recommandé de combiner le fichier robots.txt avec d’autres méthodes comme les balises meta.

Utilisation des balises meta

Les balises meta offrent une autre méthode pour contrôler l’indexation et l’exploration de vos pages web. Elles permettent de spécifier des directives précises directement dans le code HTML de chaque page.

La balise meta robots

La balise meta robots est insérée dans l’en-tête () du fichier HTML d’une page. Elle peut être utilisée pour indiquer aux moteurs de recherche de ne pas indexer une page ou de ne pas suivre les liens qu’elle contient.

<meta name="robots" content="noindex, nofollow">

Dans cet exemple, noindex indique que la page ne doit pas être indexée, et nofollow spécifie que les liens sur cette page ne doivent pas être suivis.

Avantages et inconvénients

L’utilisation des balises meta est plus granulaire et directe que le fichier robots.txt. Elles permettent de contrôler l’indexation de façon plus précise, sans dépendre de l’infrastructure du serveur. Cependant, elles nécessitent une modification du code HTML, ce qui peut être plus complexe à gérer, surtout pour les sites de grande envergure.

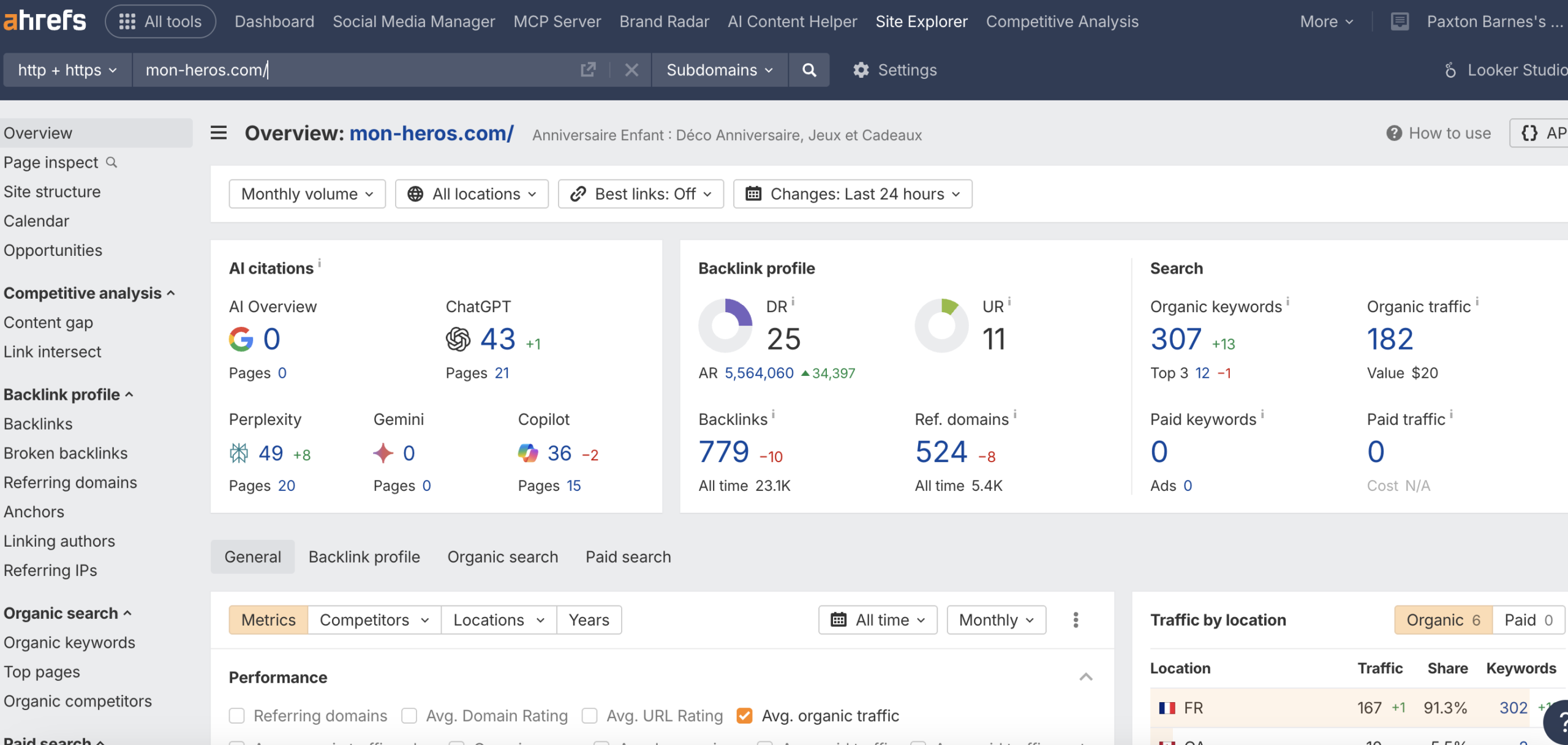

Google Search Console et Screaming Frog

Pour ceux qui cherchent des outils robustes pour gérer l’indexation et le crawl, Google Search Console et Screaming Frog sont des alliés précieux.

Google Search Console

Google Search Console est une plateforme gratuite qui offre une multitude de fonctionnalités pour gérer l’indexation et le SEO. Vous pouvez y soumettre votre fichier robots.txt, analyser les erreurs de crawl, et même demander le retrait de pages spécifiques des résultats de recherche.

Screaming Frog

Screaming Frog SEO Spider est un outil de crawl qui permet d’analyser en profondeur les pages web de votre site. Il vous aide à identifier les pages à indexer ou non, à trouver les erreurs et à optimiser votre budget crawl.

En utilisant ces outils de manière conjointe, vous pouvez obtenir un contrôle précis et une analyse complète de la visibilité de votre site sur le web.